本文目录一览:

中国人工智能伦理治理的核心原则是

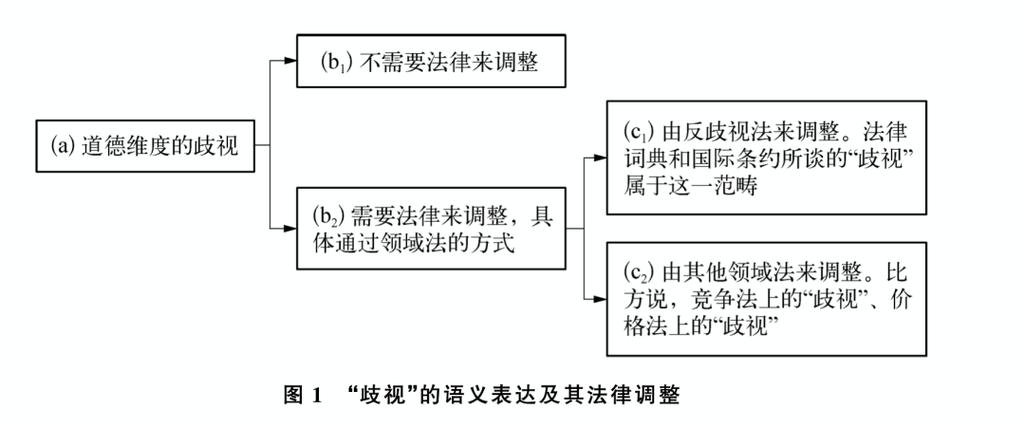

1、中国人工智能伦理治理的核心原则包括有益性原则、公正性原则、尊重人权原则、透明性原则和安全性原则。有益性原则:强调人工智能技术的发展和应用应当对社会和人类有益,促进经济社会的可持续发展,提高人民的生活质量和幸福感。公正性原则:要求人工智能技术的使用应当公平、公正,避免造成社会不公和歧视。

2、《治理原则》强调发展和谐友好、公平公正、包容共享、尊重隐私、安全可控、共担责任、开放协作、敏捷治理的人工智能系统。其中,安全可控原则要求人工智能系统不断提升透明性、可解释性、可靠性、可控性,确保系统的可审核、可监督、可追溯、可信赖,并增强其鲁棒性和抗干扰能力。

3、治理原则突出了发展负责任的人工智能这一主题,强调了和谐友好、公平公正、包容共享、尊重隐私、安全可控、共担责任、开放协作、敏捷治理等八条原则。

4、人工智能伦理的基本原则主要有以下四点:人类优先:人工智能技术的设计与应用需以服务人类为核心目标,而非取代人类。其旨在提升人类生活质量、增强工作效率,辅助人类解决各类问题。公平性:人工智能系统应确保公平公正,避免在数据处理、决策过程中对特定群体产生歧视或偏见,保证对所有个体和群体一视同仁。

人工智能有哪些伦理问题?

人工智能面临的伦理问题主要有以下几个方面:数据隐私问题:人工智能在数据收集、存储、处理过程中,容易泄露个人隐私,这违背了个人隐私权利,也可能导致安全问题的出现。如何在确保数据隐私的前提下利用数据,是人工智能发展中需要解决的重要伦理问题。

技术滥用与恶意攻击:AI技术可能被恶意使用,如深度伪造技术用于诈骗或造谣。此外,AI系统也可能成为黑客攻击的目标,导致数据泄露或系统瘫痪。长期存在的超级智能风险:虽然这还是个遥远的问题,但不得不提。

对隐私权的威胁 人工智能时代以大数据为基础,对个人隐私构成了前所未有的威胁。隐私权,即个人生活的私密空间和个人信息的秘密,虽然宪法中未明确提及,但在民法中得到了强有力的保护。在智能技术的监控下,个人的生活细节被详细记录,个人信息被轻易收集分析。

人工智能引发的伦理问题包括: 隐私权的威胁 隐私权作为基本人权,虽在宪法中未明确,却在民法中得到强力保护。它指的是自然人享有私人生活空间和个人信息秘密不受干扰和侵犯的权利。然而,在大数据支撑的智能时代,人们的隐私权受到前所未有的冲击。

道德和价值观问题:人工智能系统在决策过程中可能无法完全遵循公正和公平的原则,尤其是在贷款审批、犯罪侦查等领域。 就业问题:人工智能和自动化技术可能会导致某些工作岗位的消失,并对就业市场产生长远影响。

算法歧视:看不见的不正义

算法歧视是一种看不见的不正义,它体现在人工智能算法决策过程中的不透明、不准确与不公平。以下是关于算法歧视的详细解算法歧视的定义:算法歧视是指在人工智能和机器学习算法的设计、训练和应用过程中,由于数据偏见、编程人员主观判断或其他因素导致的系统性歧视现象。

算法歧视是一种在人工智能算法决策过程中潜在的不公正现象。算法歧视的存在:在购物推荐、就业评估、犯罪评估等多个领域,人工智能算法看似公正,实则可能隐藏着无法察觉的歧视。微软的Tay事件、图像识别软件的种族偏见,以及谷歌和亚马逊推荐系统中的不公平现象,都是算法歧视的具体案例。

算法决策背后的数据质量至关重要,数据的不准确、不完整或偏见可能导致系统性歧视。算法可能继承人类决策的偏见,甚至放大歧视现象。理解算法决策过程,确保算法设计的公平性,成为关键。算法决策预测趋势,但其预测结果受算法模型和数据输入影响。

算法的阴影:看不见的不公正揭示 在我们日常生活中的诸多领域,人工智能算法正悄然扮演着决策者的角色,从购物推荐到就业评估,它们看似公正,却可能潜藏着无法察觉的歧视。微软的Tay事件和图像识别软件的种族偏见,以及谷歌和亚马逊的推荐系统中的不公平现象,正是这种算法歧视的冰山一角。

算法偏见:看不见的“裁决者”我们生活在被AI算法包围的时代,技术的进步让AI突破了过去的使用边界,深入到决策领域,对我们的生活产生了重要影响。然而,一个不容忽视的问题也随之浮现——算法偏见。算法偏见的典型类别 技术的包容性不足 技术的包容性不足是算法偏见的一种典型表现。

算法歧视不仅损害用户利益,更会激化社会的原有偏见。调研发现,新闻推送中的女性、老年人等弱势群体更容易受到人们的关注,有67%的受访者认为“女司机”“女大学生”等带有性别指向的词汇更容易上热搜,性别议题更易激起讨论。

人工智能的伦理风险及治理

为了应对上述伦理风险,人工智能伦理治理显得尤为重要。人工智能伦理治理是指通过制定和实施一系列的规范和措施,确保人工智能技术的研发和应用符合道德和法律标准,以保障人类的利益和安全。具体治理措施包括:规范研发和应用 制定严格的研发和应用规范,确保AI技术符合道德和法律标准,避免出现偏见、歧视、隐私和信息泄露等问题。

人工智能带来的伦理问题主要包括失控风险、恶意使用、适应性风险、认知风险等,其应对措施包括建立普遍的人工智能伦理规范、推动终身学习以及鼓励创新和创意领域的发展。人工智能带来的伦理问题 失控风险:人工智能系统的自主决策能力可能导致其行为超出人类控制范围,从而引发安全风险。

中国关于加强人工智能伦理治理的立场文件,体现了中国对人工智能伦理问题的深刻认识和高度重视。

第五条:推动敏捷治理,持续优化治理机制和方式,有序推动人工智能健康和可持续发展。第六条:积极实践示范,将人工智能伦理道德融入管理全过程,及时总结推广治理经验。第七条:正确行权用权,明确职责和权力边界,保障相关主体的合法权益。

监控环节,部署动态风险评估模块,实时检测用户交互中的潜在伦理风险(如诱导性言论),并触发人工复核流程,2023年累计拦截违规操作12万次。修正机制上,公司开源了伦理干预工具包,允许开发者自定义AI行为边界,例如限制医疗机器人仅提供诊断建议而非治疗决策。

什么是AI伦理?

定义与重要性:人工智能伦理是指探讨和研究人工智能技术在设计、开发、应用过程中所涉及的道德、伦理和社会影响问题。随着AI技术的广泛应用,其对社会秩序、个人隐私、公平性等方面提出了严峻考验,因此AI伦理成为了一个备受关注的领域。核心议题:AI伦理的核心议题包括公平性、隐私权和安全性。

AI在学术活动中的应用:AI工具的广泛使用对学术诚信带来了挑战。特别是AI生成内容的归属认定、贡献比例量化、检测技术准确性等问题,都涉及到学术伦理的规范与监管。如何确保学术活动的公正性和真实性,是AI在学术领域应用中必须面对的伦理问题。

AI伦理框架的未来展望 未来,AI的伦理框架应结合肯定性原则的指导性和否定性规则的约束性,形成更全面、更灵活的体系。这种转变不仅有助于AI的发展,也将为人类带来更多福祉。

表现:例如,在AI事故发生时,责任难以界定,可能导致法律纠纷和社会信任危机。人工智能伦理治理 为了应对上述伦理风险,人工智能伦理治理显得尤为重要。人工智能伦理治理是指通过制定和实施一系列的规范和措施,确保人工智能技术的研发和应用符合道德和法律标准,以保障人类的利益和安全。

本文来自作者[qsnshb]投稿,不代表全胜号立场,如若转载,请注明出处:https://www.qsnshb.cn/meiri/202509-5891.html

评论列表(3条)

我是全胜号的签约作者“qsnshb”

本文概览:本文目录一览: 1、中国人工智能伦理治理的核心原则是 2、人工智能有哪些伦理问题?...

文章不错《算法歧视治理(AI伦理审查)(算法歧视其实是指)》内容很有帮助